Oggi vogliamo condividere con tutti voi la nostra esperienza nel condurre i cosiddetti “SEO AUDIT” per i siti web, ovvero, l’arte di effettuare tutti i check necessari a capire e risolvere le varie criticità in termini di SEO, per permettere ad un sito di posizionarsi e guadagnare visibilità nei motori di ricerca.

Il primo passo per un’analisi SEO di un sito web è armarsi di pazienza, un termos di caffè e degli strumenti giusti: i passaggi da fare sono molti, soprattutto se si vuole andare in profondità ed approfondire tutti gli aspetti tecnici e non.

SEO Audit: dominio[/text_2]

Il primo vero controllo quando cominciamo ad eseguire la nostra analisi è ovviamente il dominio. Il dominio è composto principalmente da due parti:

- Il TLD (top level domain), detto anche dominio di primo livello o estensione del dominio, è la parte finale che compone il dominio. Ad esempio, per il dominio: example.com, il TLD è “.com”. La scelta del TLD non grava particolarmente sul ranking del sito a livello SEO, ma è comunque consigliato utilizzare TLD internazionali per siti multilingue (come .com, .net, .org) e TLD nazionali per siti con una sola lingua o localizzati (ad esempio: .it, .fr, .de), in quanto il motore utilizza questi ultimi per comprendere meglio il mercato di riferimento del sito.

- Il dominio di secondo livello è la parte che precede il dominio di primo livello. Ad esempio per il dominio “example.com”, il dominio di secondo livello è “example”.

La scelta del dominio, inteso come composizione del TLD unito al dominio di secondo livello, è molto importante. Ogni dominio, infatti, può godere di un certo livello di popolarità e autorità, legata alla sua storicità. Vedremo successivamente questo argomento.

Prendiamo sempre come esempio example.com. Nel caso in cui il sito sia online, verifichiamo che non sia raggiungibile da altri domini, ma esclusivamente da uno solo.

Il consiglio è di investigare se esistono altri domini collegati al progetto, come ad esempio “dominio.it”, “dominio.org” oppure “dominio2.com”. Una volta ottenuta una lista verifichiamo come rispondono i domini direttamente dal nostro browser. Se caricando i vari domini si riceve un “HTTP/1.1 200 OK” allora abbiamo dei problemi di duplicazione, che è necessario risolvere immediatamente! Nella maggior parte dei casi l’utilizzo di redirect 301 e della corretta configurazione del file htaccess (nel caso di sistemi Apache) può risolvere il problema in brevissimo tempo.

Proviamo, infine, ad accedere al nostro sito con “www.” davanti (http://www.dominio.com), e senza “www” (http://dominio.com): se in entrambi i casi vediamo la stessa pagina abbiamo un problema di duplicazione molto simile a quello di duplicazione dei domini e risolvibile con poche righe di htaccess.

Un ottimo strumento per capire e vedere gli header, e se tutte le richieste sono soddisfatte o meno, è l’estensione httpfox di Firefox, necessaria in queste occasioni.

SEO Audit: onsite

Una delle parti più importanti (e che può presentare più criticità) quando si analizza un sito web è l’analisi onsite.

Per Onsite intendiamo tutti gli aspetti tecnici che possono impedire ad un motore di ricerca di indicizzare, scansionare e capire i contenuti di una determinata pagina, sezione o intero sito.

Si comincia con la validazione del codice html, anche se molto difficile da rispettare, viste le molteplici versioni dei browser e applicazioni custom, la validazione del codice HTML secondo gli standard w3c è tutt’ora una delle “best practice”.

Possiamo controllare quanto non è valido il nostro codice, direttamente nel sito del w3c: https://validator.w3.org/.

Un altro aspetto fondamentale dell’ottimizzazione onsite è l’utilizzo corretto dei codici di heading html, ovvero sezioni, capitoli, sotto capitoli in cui è suddiviso un testo.

Per approfondire l’argomento heading HTML è possibile consultare questa pagina.

Per velocizzare le operazioni di controllo sugli heading, noi utilizziamo una comodissima estensione di Firefox: headingmaps.

Disattiviamo i javascript e i cookies tramite Web Developer Toolbar, estensione che mai dovrebbe mancare nella lista delle estensioni per Firefox di un buon consulente SEO. In questo modo possiamo capire velocemente se i contenuti potranno essere accessibili da un motore di ricerca. Se così facendo ci trovassimo di fronte ad una pagina vuota, completamente bianca (o colorata), apparentemente senza contenuti testuali, ecco che abbiamo scoperto una grossa criticità da risolvere.

La tecnologia javascript è molto utile per incrementare l’esperienza utente tramite animazioni ed effetti piacevoli, ma l’abuso può essere invalidante per l’accesso ai contenuti da parte dei motori di ricerca.

Da qualche mese a questa parte, con il cosiddetto “mobilegeddon” Google accredita sempre più valore all’esperienza dell’utente che naviga tramite dispositivo mobile, anche come fattore di posizionamento. Dotare il proprio sito di un layout responsive, ovvero adattabile a tutte le risoluzioni, è una buona soluzione lato SEO, in quanto si evita la duplicazione di contenuti e il lavoro necessario al mantenimento di 2 piattaforme distinte, desktop e mobile.

Possiamo navigare il sito in modalità mobile, senza utilizzare un cellulare, con l’ausilio di User agent switcher, un’estensione che può tornarci utile in questi casi!

Ora è il turno di controllare se ci sono direttive restrittive o errori che possono bloccare gli spider dei motori di ricerca: possiamo cominciare con il consultare il file robots.txt

che dovrebbe aprirsi digitando il nostro dominio, ad esempio http://dominio.ext/robots.txt .

Attenzione: modificare senza cognizione di causa questo file può nuocere gravemente al posizionamento, maneggiare con cautela.

All’apertura del file dovremmo poter vedere una serie di istruzioni, molto simili alle seguenti:

# robots.txt

User-agent: *

Disallow:

Sitemap: http://www.dominio.ext/sitemap_index.xml

Le direttive contenute in questo file indicano ai motori di ricerca se ci sono risorse che possono essere escluse dal loro crawling e indexing.

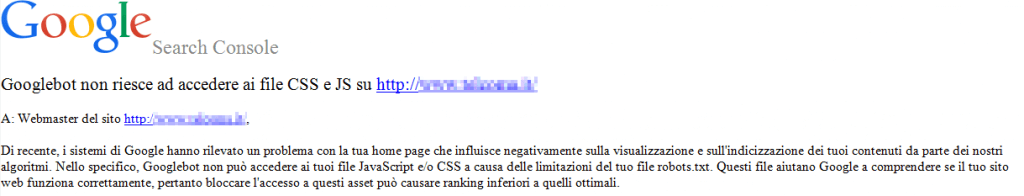

Ricordiamoci inoltre di permettere a Google di accedere ai nostri javascript e css di template (o potrebbe anche ricordarcelo lui!).

Nelle direttive del robots.txt dovrebbe essere presente il link alla sitemap.xml.

La sitemap.xml è un file che contiene la lista delle pagine del sito. Viene letta dai motori di ricerca ed è molto utile in caso di siti molto estesi o aggiornati di frequente, come blog, e-commerce e magazine. Fornisce l’alberatura del sito, il che è di grande aiuto per gli spider, agevolando cosi l’indicizzazione di pagine e contenuti.

Nella sitemap è possibile dare delle priorità di scansionamento a determinate pagine o sezioni, in particolare a quelle che subiscono variazioni più frequenti.

SEO Audit: contenuti

Se pensiamo a Google come al “grande bibliotecario del web”, dobbiamo ricordarci che ama i contenuti originali, ordinati e ben categorizzati.

Gli spider di Google, dopo aver scansionano e indicizzato il contenuto di un sito, lo mettono in relazione agli altri siti con contenuti correlati, per poi elencarli a seguito di una ricerca in ordine di rilevanza. Rilevanza che viene calcolata dai tantissimi algoritmi di ranking.

Per questo motivo, mentre analizziamo i nostri contenuti, dobbiamo fare in modo che le informazioni che riteniamo più interessanti siano le più facili da trovare. Questa operazione è fondamentale quando si sceglie l’architettura informativa del nostro sito.

Prima di progettare l’albero dei nostri contenuti, inoltre, è bene capire come interagiranno gli utenti con i contenuti stessi. Google è sempre più attento ai flussi di navigazione e usabilità delle pagine web.

A braccetto con l’alberatura del sito, arriva la configurazione della struttura delle URL. Meglio pochi livelli di directory, o un albero con foglie profonde?

Riscrittura tramite htaccess o parametri?

Queste sono alcune domande che bisognerebbe sempre porsi nel progettare la struttura delle URL.

Ovviamente dipende dalla complessità e dal numero totale di categorie e sottocategorie che andranno pubblicate.

In generale, se possibile, optiamo per url brevi e riscritte.

Ricordiamo, inoltre, che un utilizzo corretto dei “breadcrumbs” risulta molto utile per indicare al motore la struttura del sito.

Facciamo in modo che le nostre pagine più importanti siano ben linkate sia internamente da pagine “correlate”, sia esternamente. Ogni link è un voto verso di noi agli occhi degli spider!

Controlliamo che ogni pagina abbia la giusta posizione nella struttura del sito, sufficienti contenuti, meta tags rilevanti e ben compilati.

Se sono presenti immagini e video, tagghiamoli con il corretto markup ed eventualmente con i microformati schema.org per arricchirne la visualizzazione in SERP.

La nostra attenzione ora andrà verso le pagine di categoria, o sottocategorie, dove troviamo spesso la paginazione dei contenuti. Verifichiamo di utilizzare correttamente i tag rel “prev” e “next”, facciamo così capire al motore di ricerca come sono strutturate le nostre pagine “lunghe”. Ecco un ottimo link di approfondimento di questo argomento.

Controlliamo se ci sono contenuti duplicati o pagine simili.

Dove non possiamo agire accorpando o modificando questi contenuti possiamo utilizzare la direttiva “canonical” per indicare al motore quale è la pagina preferita per l’indicizzazione e la presenza in SERP.

Ulteriori informazioni sulla gestione delle direttive canonical sono disponibili a questo indirizzo.

Un eccellente strumento per l’analisi dei contenuti e di buona parte dei fattori onsite è Screaming Frog, un simulatore di spider che effettua una scansione di tutte le pagine di un sito web e consente di evidenziare problematiche relative ai meta tag, alla struttura dell’url e molto altro ancora.

SEO Audit: link profile

Gli update costanti di Google hanno portato negli anni molte variazioni negli algoritmi e nel modo in cui essi calcolano il valore e l’affidabilità di un link.

Buona norma è quella di tenere sempre sotto osservazione i link in ingresso. In questo modo è possibile evitare penalizzazioni e avere il controllo sulla situazione del proprio link profile.

Essere linkati da un alto numero di risorse di buona qualità è una regola imprescindibile.

Uno strumento molto utile per analizzare la qualità dei link e le anchor text in ingresso, oltre alla autorità di un dominio, è Majestic. Grazie a questo tool possiamo effettuare analisi di benchmarking tra competitor e “reverse engineering” della popolarità tra domini.

Link popularity non vuol dire solo ottimizzare i link in ingresso, ma anche gestire i link in uscita.

I link in uscita sono un indicatore utilizzato dal motore di ricerca per comprendere l’affidabilità e la tematicità del sito. I link collegano fra di loro contenuti. Quindi collegare il sito a una risorsa esterna affidabile, che magari offre anche contenuti tematici simili al sito, è sicuramente un sintomo di qualità.

SEO Audit: lato server

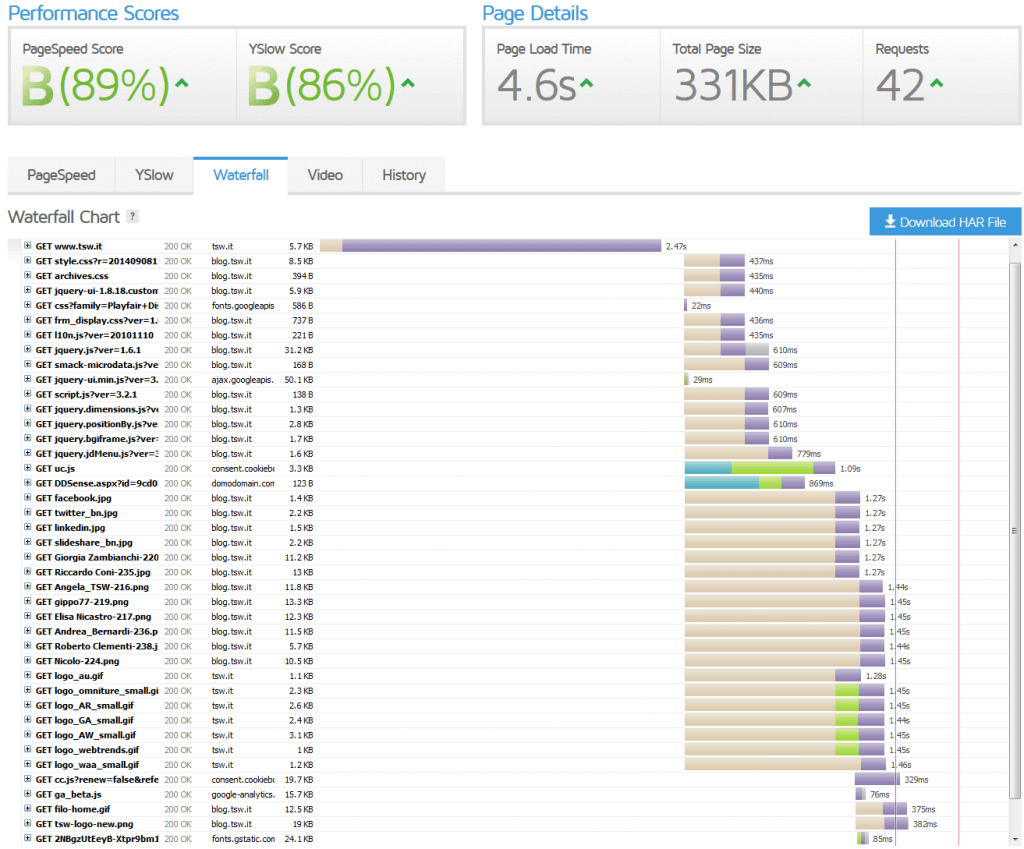

Gestire correttamente il server dove è ospitato il nostro sito è un aspetto fondamentale per due ragioni:

- la velocità di risposta incrementa l’esperienza di navigazione degli utenti, che difficilmente permangono in un sito lento da navigare o non “reattivo” al cambio pagina o click del mouse

- è uno dei fattori di ranking preso in considerazione dagli algoritmi di Google.

Se il nostro hosting è Linux, accertiamoci di avere il webserver Apache configurato nel modo migliore, abilitando la compressione gzip, l’expire degli headers per i file più statici del nostro sito. Disattiviamo, inoltre, gli ETag, evitiamo i redirect 301 dove non sono necessari e minimizziamo le richieste a DNS esterni.

Non lesiniamo sulle caratteristiche tecniche, quali CPU, RAM e larghezza di banda in modo da avere risposte veloci e reattive anche a richieste simultanee di più utenti.

La sicurezza e l’affidabilità del server è un aspetto da tenere in considerazione, Google non ama i siti che vanno offline o che generano errori (500 internal server error) e potrebbe penalizzarli. Allo stesso modo Google difficilmente proporrà fra i suoi risultati un sito contenente malware.

Accertiamoci con il nostro fornitore di poter avere accesso ai log del webserver, dove potremmo scoprire errori, pagine richieste non più disponibili, richieste non soddisfatte e porvi rimedio sia per gli utenti, sia per gli spider dei motori di ricerca.

Google, nel suo voler rendere il web più sicuro, prenderà in considerazione il sito anche se questo è disponibile tramite una connessione cifrata HTTPS. L’installazione e configurazione del sito tramite protocollo con certificato SSL è una richiesta da fare all’IT!

SEO Audit: analisi e dati

Le fonti di dati sono un punto fondamentale per concludere una analisi SEO. Migliore è la qualità dei dati, più precise potranno essere poi le conclusioni finali.

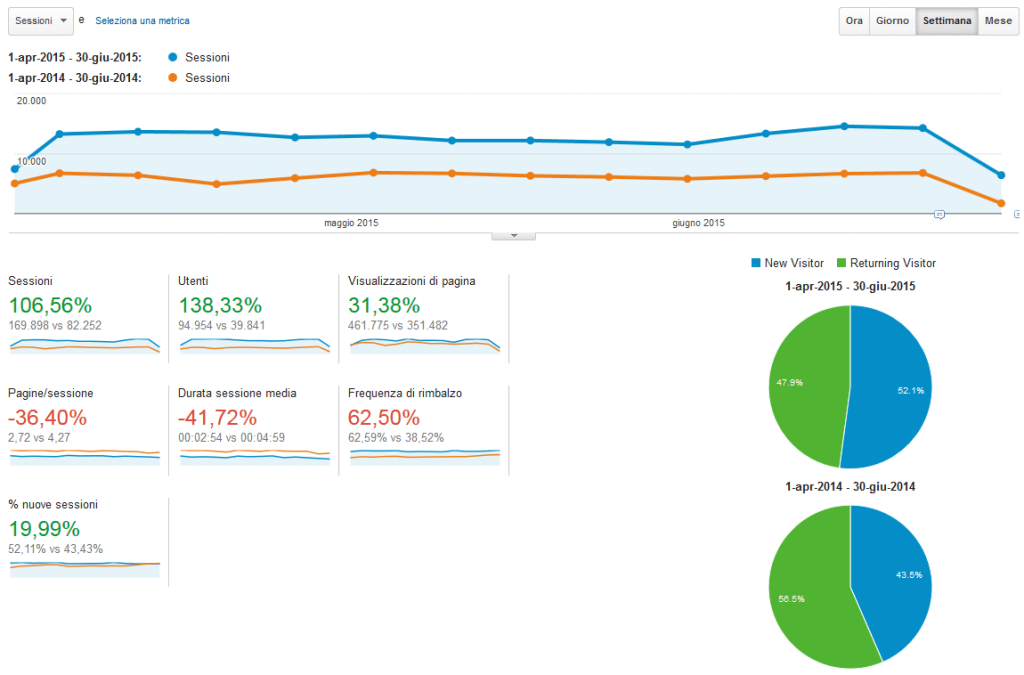

Google Analytics è un eccellente strumento per raccogliere dati a fini SEO.

Con Google Analytics possiamo analizzare l’andamento del traffico organico nel tempo, intercettare i contenuti più interessanti per gli utenti, le pagine principali di atterraggio, eventuali pagine di errore 404, e agire di conseguenza.

Analytics migliora ulteriormente se connesso alla Google Search Console.

Google Search Console (ex Google Webmaster Tools) è un pannello che Google stesso mette a disposizione per fornire interessanti dati raccolti dal motore di ricerca.

Dopo aver tolto la possibilità di vedere le keyword di ingresso direttamente nei report di Analytics, oscurandole tramite “not provided”, il collegamento attraverso GSC è l’unico modo per ottenere dati sulle parole chiave utilizzate dagli utenti per accedere al sito.

Possiamo perciò avere una panoramica delle impression e dei click che il nostro sito genera nelle SERP e ricavare dati utilissimi di CTR e posizione media.

Inoltre, attraverso messaggi inviati direttamente da Google è possibile individuare possibili penalizzazioni o azioni manuali intraprese sul sito.

Altri dati fondamentali per concludere la nostra analisi SEO, possono arrivare dai Tool online e offline. Preziosi consigli sul posizionamento attuale e dei nostri principali competitor possono essere scoperti tramite il servizio dedicato di SEMRush.

SEO Audit: Conclusioni

Se arrivati a questo punto iniziate a entrare nell’ottica della complessità e dell’ampiezza di competenze richieste a un consulente SEO, ma considerate che siete solo all’inizio.

L’analisi SEO, o SEO audit, rappresenta il punto di partenza necessario e primario per intraprendere qualsiasi attività.

Avendo una fotografia chiara e precisa dello status iniziale di un sito web è possibile procedere e intervenire con le ottimizzazioni, in piena coscienza dell’intero progetto e della direzione da perseguire.

Se hai bisogno di un SEO audit per la tua azienda, non esitare a contattarci!

Se hai già molta familiarità con gli argomenti trattati e non hai letto niente di nuovo in questo articolo… siamo sempre alla ricerca di bravi SEO per allargare il nostro team!

Contributi e ringraziamenti per l’articolo:

Dario Codato

Lorena Piai

Mino Bedin